(.NET Core ではないクラシカルな) ASP.NET Web アプリ開発と、Azure Web App への配置における、データベース接続文字列をどこにどう設定するのか、の話題。

本投稿では、SQL Server データベースに接続して、何かしらデータベースに読み書きする ASP.NET Web アプリを想定している。

そしてデータベースアクセスライブラリには Entity Framework を用い、Code Fist スタイルで実装するものとする。

まずはおさらいから。

開発環境では...

開発環境、およびバージョン管理システムにコミットされる内容としては、web.config の connectionStrings セクションに、SQL Server LocalDB によってプロジェクトフォルダ以下にデータベースファイルができあがるように、データベース接続文字列をインラインで記述する。

<?xml version="1.0" encoding="utf-8"?>

<configuration>

<connectionStrings>

<add

name="MyDB"

connectionString="Server=(LocalDB)\MSSQLLocalDB;AttachDbFilename=|DataDirectory|MyDB.mdf;Integrated Security=True;Connect Timeout=30"

providerName="System.Data.SqlClient"/>

</connectionStrings>

...

</configuration>

このコード・構成ファイルをバージョン管理システムにコミットしておくことで、このリポジトリを clone (あるいはチェックアウト) した他のメンバーも、ビルドして実行するだけで、データベースも新規構築されてその ASP.NET Web アプリを動かすことができる。

もっとも、最低限、いずれのメンバーの開発環境にも、同じバージョンの SQL Server LocalDB が事前にインストール済みである必要はある。

とはいえ、そもそも ASP.NET Web アプリ開発のために Visual Studio が必要という程度には各メンバーの開発環境をそろえる手間をかけているはず。

なので、さらに SQL Server LocalDB についても環境をそろえることは大したコスト、問題にはならないと思う。

実行環境では...

さてこうして開発した ASP.NET Web アプリを、Azure Web App として配置するとしよう。

上記手順で開発したとすれば、接続先データベースに LocalDB が指定された web.config が配置されることになる。

しかし当然のことながら、一般的(?)なケースであれば、実行環境用のデータベースは LocalDB ではなく Azure 上の SQL Database サービスなどを別途用意済みで、そちらに接続するようにしたいはずだ。

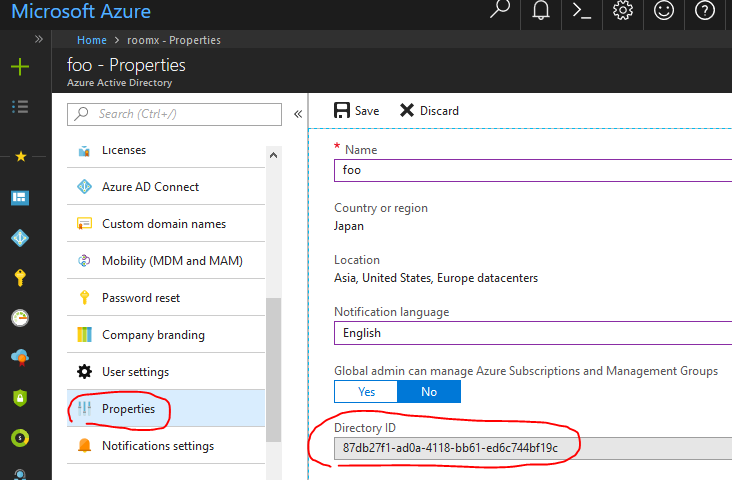

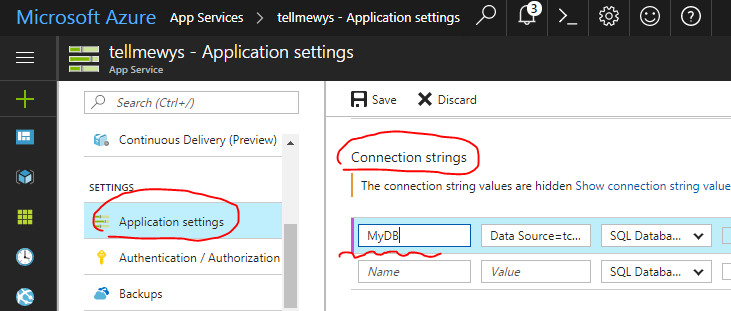

このような目的で、Azure Web App のアプリケーション構成の中に、データベース接続文字列をポータル上から指定できるようになっている。![d0079457_21420390.png]()

web.config の connectionStrings セクションと、この Azure のポータル設定とで同じ名前のエントリがあると、Azure のポータルで設定したデータベース接続文字列のほうが優先して採用されるのだ。

この仕掛けにより、

本番環境用のデータベース接続文字列をバージョン管理システムにコミットすることなく、

またいっぽうで開発者はソースコードリポジトリからプロジェクト一式を取り出したらすぐにローカル環境で実行できる

体制とすることができる。

開発環境側で、異なるデータベース接続がしたい!

...と、ここまではおさらい。

それなりに ASP.NET Web アプリ開発や Azure への配置を手掛けている経験があれば、ここまでの内容は半ば "常識" かもしれない。

さて、以上の仕組み・体制で大抵の場合は問題ない。

しかし稀ではあるものの、開発環境においてデータベース接続文字列を変更したい需要がある。

いくつかの面倒なシナリオがあるのだが、わかりやすい例としては、開発環境にインストールされている SQL Server LocalDB のバージョンが合っていなかった、という例が挙げられる。

久々に古いプロダクトのコードを開いて実行してみたら、開発機を入れ替える前のコードで、現在の開発機にはそのプロダクトが指している古いバージョンの SQL Server LocalDB がインストールされていなかった、とかである。

LocalDB 2014を使っている場合、接続文字列はData Source=(LocalDb)\v11.0 じゃないし v12.0 でもないし ProjectsV12 でもなく、正解はData Source=(LocalDb)\MSSQLLocalDB でした。お疲れ様でした。— ちきさん (@ovrmrw) April 1, 2015

まぁ普通に考えると、指定のバージョンの SQL Server LocalDB をインストールすればよいのだろう。

しかしながら、いろんなバージョンの SQL Server LocaDB が開発機にインストールされるのは (しかもそのようなレアなプロダクトの保守のためだけに)、気持ち悪いかもしれない。

そんなことから指定バージョンの SQL Server LocalDB のインストールを嫌って、web.config にインラインで記載されているデータベース接続文字列を、自身の開発機にインストールされている SQL Server LocalDB バージョンに合わせて書き換えてしまい、これをコミットしてしまうと、あまり致命的ではないとはいえ (どうせ Azure に配置するときにはポータルで設定された接続文字列が使われるので問題ない)、開発メンバー間で面倒なことになりかねない。

「あいつのコミットをマージしたら、自分の環境で動かなくなったー!」みたいに、である。

ということで、最近編み出した手法を紹介する。

解決方法まず、データベース接続文字列は、web.config にインラインで記述せず、web.config 中からは (例えば) "connectionStrings.config" という、もうひとつ外部の構成ファイルを参照するように変更する。

<?xml version="1.0" encoding="utf-8"?>

<configuration>

<connectionStrings configSource="connectionStrings.config" />

...

</configuration>

いっぽうで、バージョン管理システムには、ファイル "connectionStrings.config" がバージョン管理下に含まれないようにしておく。

git であれば .gitignore に "connectionStrings.config" の1行を加筆しておくことになるだろう。

さてこれだけだと、新たにバージョン管理リポジトリからプロジェクト一式を clone しても、"connectionStrings.config" がないので、ビルドや実行時エラーになってしまう。

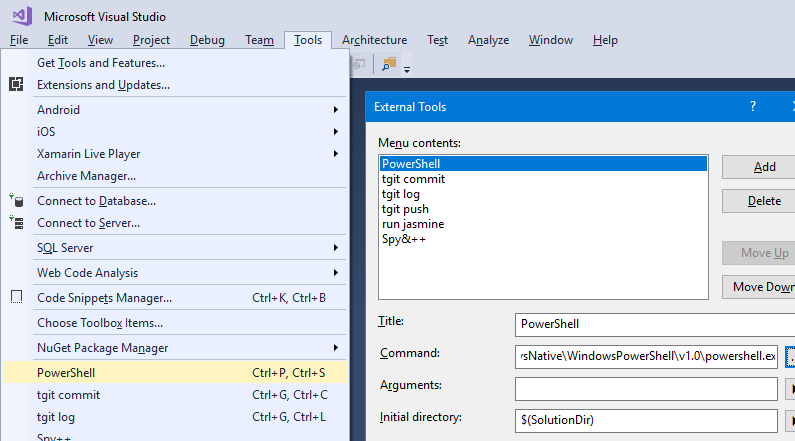

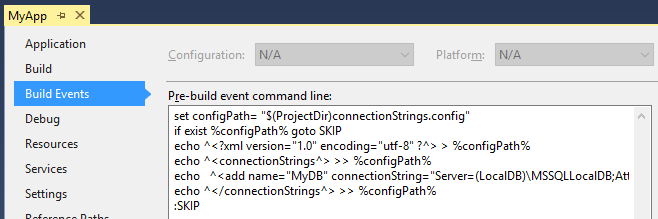

そこで、ビルドイベントの「ビルド前に実行」されるバッチスクリプトとして、

「もし "connectionStrings.config" がプロジェクトフォルダに存在しなければ、既定の内容で生成」

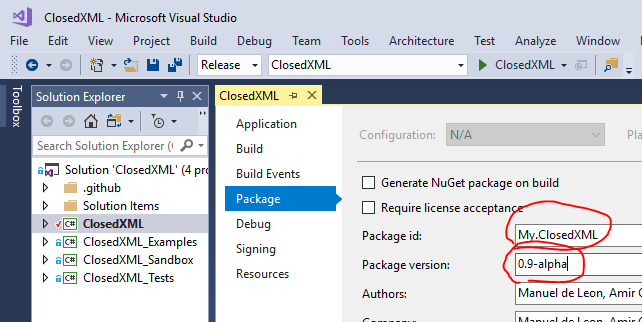

というバッチスクリプトをプロジェクトファイルに組み込んでおくのだ (下記例)。![d0079457_21542140.png]()

if exist %configPath% goto SKIP

echo ^<?xml version="1.0" encoding="utf-8" ?^> > %configPath%

echo ^<connectionStrings^> >> %configPath%

echo ^<add name="MyDB" connectionString="Server=(LocalDB)\MSSQLLocalDB;AttachDbFilename=|DataDirectory|MyDB.mdf;Integrated Security=True;Connect Timeout=30" providerName="System.Data.SqlClient"/^> >> %configPath%

echo ^</connectionStrings^> >> %configPath%

:SKIP

※上記例以外にも、別途既定の構成の "connectionStrings.config" ファイルをバージョン管理下にはあるがプロジェクトフォルダの外に「テンプレート」として配置しておき、プロジェクトフォルダになければコピー、といった仕組みとすることもできるだろう。

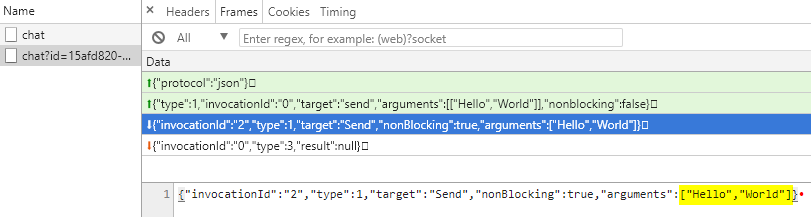

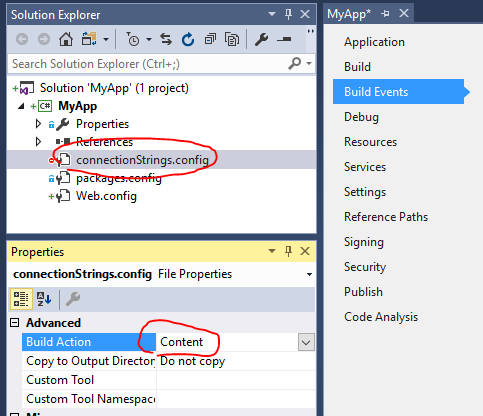

あとは、"connectionStrings.config" をプロジェクトに含め発行対象となるようにしておけばよい。

![d0079457_22025173.png]()

こうしておくことで、

開発者はこれまでどおり、プロジェクト一式をバージョン管理リポジトリから clone した直後、そのままビルド、実行してもちゃんとアプリを動かすことができるいっぽう、

データベース接続文字列を記述している "connectionStrings.config" はバージョン管理下にないので、安心して自分の好きなように接続先データベースを書き換えて実行

といったことができる。

まとめ

ここで紹介したやり方は、実のところ、あまり美しいやり方とは言えないと思う。

実際、もしも Azure Web App への配置が CI/CD の仕組みではなく手動による配置だと、配置を行うメンバーが "connectionStrings.config" を既定とは違う内容に書き換えていたら、それが Azure 上に配置されてしまうという気持ち悪さもある。

(どのみち、ポータルで設定されたデータベース接続文字列に上書きされて動作するはずなので、実害はないはずだが)

とはいえ、本記事で取り上げたような需要 ― 既定のデータベース接続文字列を開発者間で共有しつつ、自分独自のデータベース接続文字列に書き換えたいときがある ― を、とにかくは満たしてはいる。

広く勧める技法ではないが、同じような需要に迫られてお困りの方の一助になれば幸いである。

よりクールでスマートなやり方・運用があればご教示いただければ嬉しい限り。

最後に補足として、ASP.NET Core ではアプリケーション構成の仕組みが変わっているので本記事は参考にならないと思うので悪しからず。

本投稿では、SQL Server データベースに接続して、何かしらデータベースに読み書きする ASP.NET Web アプリを想定している。

そしてデータベースアクセスライブラリには Entity Framework を用い、Code Fist スタイルで実装するものとする。

まずはおさらいから。

開発環境では...

開発環境、およびバージョン管理システムにコミットされる内容としては、web.config の connectionStrings セクションに、SQL Server LocalDB によってプロジェクトフォルダ以下にデータベースファイルができあがるように、データベース接続文字列をインラインで記述する。

<?xml version="1.0" encoding="utf-8"?>

<configuration>

<connectionStrings>

<add

name="MyDB"

connectionString="Server=(LocalDB)\MSSQLLocalDB;AttachDbFilename=|DataDirectory|MyDB.mdf;Integrated Security=True;Connect Timeout=30"

providerName="System.Data.SqlClient"/>

</connectionStrings>

...

</configuration>

このコード・構成ファイルをバージョン管理システムにコミットしておくことで、このリポジトリを clone (あるいはチェックアウト) した他のメンバーも、ビルドして実行するだけで、データベースも新規構築されてその ASP.NET Web アプリを動かすことができる。

もっとも、最低限、いずれのメンバーの開発環境にも、同じバージョンの SQL Server LocalDB が事前にインストール済みである必要はある。

とはいえ、そもそも ASP.NET Web アプリ開発のために Visual Studio が必要という程度には各メンバーの開発環境をそろえる手間をかけているはず。

なので、さらに SQL Server LocalDB についても環境をそろえることは大したコスト、問題にはならないと思う。

実行環境では...

さてこうして開発した ASP.NET Web アプリを、Azure Web App として配置するとしよう。

上記手順で開発したとすれば、接続先データベースに LocalDB が指定された web.config が配置されることになる。

しかし当然のことながら、一般的(?)なケースであれば、実行環境用のデータベースは LocalDB ではなく Azure 上の SQL Database サービスなどを別途用意済みで、そちらに接続するようにしたいはずだ。

このような目的で、Azure Web App のアプリケーション構成の中に、データベース接続文字列をポータル上から指定できるようになっている。

web.config の connectionStrings セクションと、この Azure のポータル設定とで同じ名前のエントリがあると、Azure のポータルで設定したデータベース接続文字列のほうが優先して採用されるのだ。

この仕掛けにより、

本番環境用のデータベース接続文字列をバージョン管理システムにコミットすることなく、

またいっぽうで開発者はソースコードリポジトリからプロジェクト一式を取り出したらすぐにローカル環境で実行できる

体制とすることができる。

開発環境側で、異なるデータベース接続がしたい!

...と、ここまではおさらい。

それなりに ASP.NET Web アプリ開発や Azure への配置を手掛けている経験があれば、ここまでの内容は半ば "常識" かもしれない。

さて、以上の仕組み・体制で大抵の場合は問題ない。

しかし稀ではあるものの、開発環境においてデータベース接続文字列を変更したい需要がある。

いくつかの面倒なシナリオがあるのだが、わかりやすい例としては、開発環境にインストールされている SQL Server LocalDB のバージョンが合っていなかった、という例が挙げられる。

久々に古いプロダクトのコードを開いて実行してみたら、開発機を入れ替える前のコードで、現在の開発機にはそのプロダクトが指している古いバージョンの SQL Server LocalDB がインストールされていなかった、とかである。

LocalDB 2014を使っている場合、接続文字列はData Source=(LocalDb)\v11.0 じゃないし v12.0 でもないし ProjectsV12 でもなく、正解はData Source=(LocalDb)\MSSQLLocalDB でした。お疲れ様でした。— ちきさん (@ovrmrw) April 1, 2015

まぁ普通に考えると、指定のバージョンの SQL Server LocalDB をインストールすればよいのだろう。

しかしながら、いろんなバージョンの SQL Server LocaDB が開発機にインストールされるのは (しかもそのようなレアなプロダクトの保守のためだけに)、気持ち悪いかもしれない。

そんなことから指定バージョンの SQL Server LocalDB のインストールを嫌って、web.config にインラインで記載されているデータベース接続文字列を、自身の開発機にインストールされている SQL Server LocalDB バージョンに合わせて書き換えてしまい、これをコミットしてしまうと、あまり致命的ではないとはいえ (どうせ Azure に配置するときにはポータルで設定された接続文字列が使われるので問題ない)、開発メンバー間で面倒なことになりかねない。

「あいつのコミットをマージしたら、自分の環境で動かなくなったー!」みたいに、である。

ということで、最近編み出した手法を紹介する。

解決方法まず、データベース接続文字列は、web.config にインラインで記述せず、web.config 中からは (例えば) "connectionStrings.config" という、もうひとつ外部の構成ファイルを参照するように変更する。

<?xml version="1.0" encoding="utf-8"?>

<configuration>

<connectionStrings configSource="connectionStrings.config" />

...

</configuration>

いっぽうで、バージョン管理システムには、ファイル "connectionStrings.config" がバージョン管理下に含まれないようにしておく。

git であれば .gitignore に "connectionStrings.config" の1行を加筆しておくことになるだろう。

さてこれだけだと、新たにバージョン管理リポジトリからプロジェクト一式を clone しても、"connectionStrings.config" がないので、ビルドや実行時エラーになってしまう。

そこで、ビルドイベントの「ビルド前に実行」されるバッチスクリプトとして、

「もし "connectionStrings.config" がプロジェクトフォルダに存在しなければ、既定の内容で生成」

というバッチスクリプトをプロジェクトファイルに組み込んでおくのだ (下記例)。

if exist %configPath% goto SKIP

echo ^<?xml version="1.0" encoding="utf-8" ?^> > %configPath%

echo ^<connectionStrings^> >> %configPath%

echo ^<add name="MyDB" connectionString="Server=(LocalDB)\MSSQLLocalDB;AttachDbFilename=|DataDirectory|MyDB.mdf;Integrated Security=True;Connect Timeout=30" providerName="System.Data.SqlClient"/^> >> %configPath%

echo ^</connectionStrings^> >> %configPath%

:SKIP

※上記例以外にも、別途既定の構成の "connectionStrings.config" ファイルをバージョン管理下にはあるがプロジェクトフォルダの外に「テンプレート」として配置しておき、プロジェクトフォルダになければコピー、といった仕組みとすることもできるだろう。

あとは、"connectionStrings.config" をプロジェクトに含め発行対象となるようにしておけばよい。

こうしておくことで、

開発者はこれまでどおり、プロジェクト一式をバージョン管理リポジトリから clone した直後、そのままビルド、実行してもちゃんとアプリを動かすことができるいっぽう、

データベース接続文字列を記述している "connectionStrings.config" はバージョン管理下にないので、安心して自分の好きなように接続先データベースを書き換えて実行

といったことができる。

まとめ

ここで紹介したやり方は、実のところ、あまり美しいやり方とは言えないと思う。

実際、もしも Azure Web App への配置が CI/CD の仕組みではなく手動による配置だと、配置を行うメンバーが "connectionStrings.config" を既定とは違う内容に書き換えていたら、それが Azure 上に配置されてしまうという気持ち悪さもある。

(どのみち、ポータルで設定されたデータベース接続文字列に上書きされて動作するはずなので、実害はないはずだが)

とはいえ、本記事で取り上げたような需要 ― 既定のデータベース接続文字列を開発者間で共有しつつ、自分独自のデータベース接続文字列に書き換えたいときがある ― を、とにかくは満たしてはいる。

広く勧める技法ではないが、同じような需要に迫られてお困りの方の一助になれば幸いである。

よりクールでスマートなやり方・運用があればご教示いただければ嬉しい限り。

最後に補足として、ASP.NET Core ではアプリケーション構成の仕組みが変わっているので本記事は参考にならないと思うので悪しからず。